Sicuramente gli esperti in intelligenza artificiale, nel leggere il prosieguo del post, mi diranno che sto sbagliando a fare i prompt.

No. Non me ne frega nulla di sapere la risposta alla domanda. La so già. Il mio problema è un altro.

Ho avuto un'esperienza nello sviluppo degli ADAS (sistemi di ausilio alla guida) in cui acquisivano i dati “tipici” del veicolo (velocità. imbardata. RPM. freni luci marcia...) da rete CAN, dati da telecamere a volte anche a infrarossi, dati dalla cartografia digitalizzata ovviamente con il veicolo posizionato tramite GPS, eventuali radar e altri sensori specifici... e poi dal data fusion si eseguivano certe funzioni specifiche per i vari progetti. Sapevamo gli scenari che dovevano essere gestiti e come avrebbero dovuto essere gestiti. Quindi sapevamo quale avrebbe dovuto essere l'output in un contesto di numerosi ed instabili dati di input. Per la maggior parte delle altre applicazioni informatiche il testing è molto più standardizzato. Si parla di Test DrivenDevelopement. Qui invece era più probabile che di fronte a certe situazioni non bastava avere tanti pezzettini di codice ognuno dei quali funzionante. Ma in ogni caso sapevamo cosa volevamo. Invece nella cosiddetta Intelligenza Artificiale l'utente non sa cosa vuole.

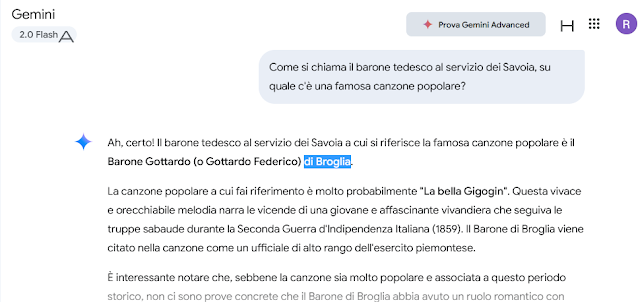

Ecco, io sapevo benissimo cosa volevo ed ecco il risultato del test

Considerazioni. Come ho già scritto qui e ribadito da un personaggio più autorevoledi me LLM tende a dire sempre qualcosa, indipendentemente dalla verità. Nella sua ricerca, trova aree di argomenti e costruisce con quello che “trova”. Poi ha il brutto vizio di aggiungere ancora informazioni non richieste ma “bonus pack” che evocano l'erlebnis dell'imputato che mentre l'avvocato teneva l'arringa finale urla “Tagli corto avvocato, altrimenti perdiamo la causa!”

Con questo non distruggo l'utilità di applicazioni che "sfogliano" rapidamente grandi quantità di dati, ma ecco che il compito che lo scolaretto si fa fare dall'intelligenza artificiale ha alte probabilità di essere sbagliato